本日の朝日新聞・社会面に、次の見出しの記事があります。

私自身、1カ月半前から、AIを積極的に使うようになりました。しかも、私の関心が高いのが、動画生成AIです。ということで、今回取り上げた記事は、身近に感じられます。

まだ、自分で動画生成AIを利用したことがない人は、それによって生成された動画を見て、実在する人が話している、と勘違いされてしまうかもしれません。

それぐらい、本物とそれほど変わらないような動画を、動画生成AIを使えば、普通の個人でも作れるようになりました。

今は、衆議院選挙の期間中です。この期間に合わせ、あるYouTube配信者が、「エンタメとして楽しんでもらう」ため、実在しない高齢女性が、テレビの街頭インタビューに答える動画を生成したそうです。

私はその動画を見たことがありません。朝日の記事で初めて知りました。

その架空の女性に、「(高市)早苗ちゃんの演説見たか? わしは胸が熱くなったわ!」などと語らせているそうです。

その動画を配信したチャンネルでは、動画はすべてAIを使って作ったと説明しているそうです。

大元の動画がどのくらいの期間見られる状態にあったのかわかりません。今月3日までに非公開とされたそうです。

本動画を、第三者がXやTikTok、スレッズなどで拡散されたのだそうです。

朝日は本事案を取り上げ、生成AIが、使い方によっては危険なものであることを読者に印象づけるような記事にしています。

たしかにその面は否めません。その技術をどのように使うか、生成AIを使う側は十分に考えなければならないことです。

ただ、そのように指摘する朝日新聞が、別の面では、AIを、場合によっては危険な状況を招きかねないことに使おうとしていることが窺われます。

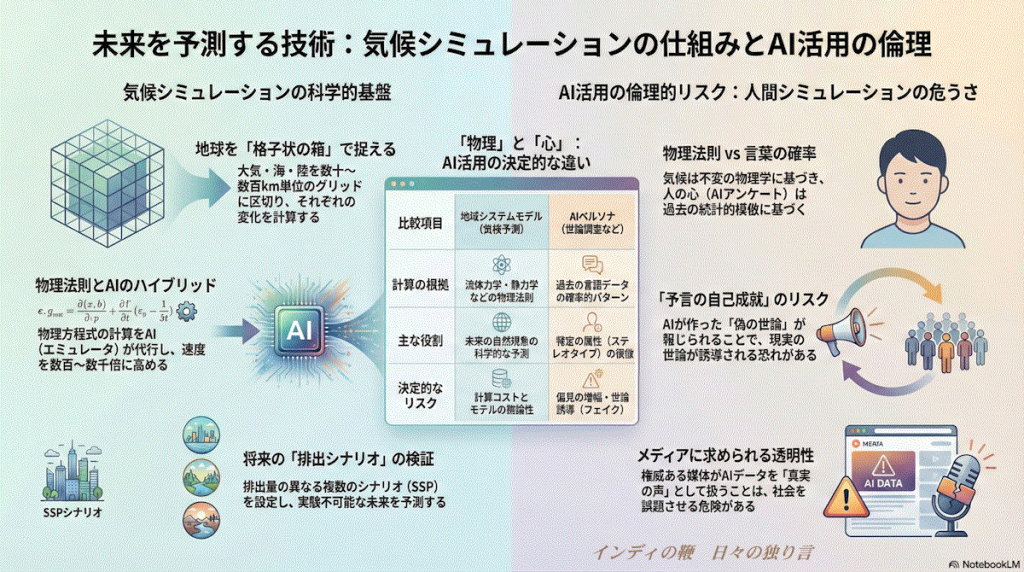

朝日新聞は、今月2日、人格(ペルソナ)を持たせたAIから、アンケートの回答を得るシミュレーション技術について伝えています。

記事には、ひとりの個人を作り出す過程が紹介されています。

一例として紹介されるのは、実在しない35歳の女性です。彼女は地方出身者です。大学進学を機に、東京に済むようになりました。

仕事は、ITエンジニアです。彼女は旅行が好きです。中でも温泉巡りをよくします。ほかには、読書やカフェ巡りを趣味としています。実家に年に数回帰省します。

彼女は、仕事とプライベートのバランスを重視し、新しい技術へ好奇心を持ちます。

どこにでもいそうな人という感じですね。ただ、似たような人がいるとしても、それぞれで、それぞれの事情があり、さまざまなことで濃淡は大きく異なるでしょう。その濃淡の度合いをAIでどれほど再現できるのだろうかと思います。

このようにして、ペルソナを持たせた上で、そのペルソナに、SNSを見せたり、選挙公報を読ませることで、データを与えます。

その上で、都道府県魅力度調査や週休3日制の利用希望、2025年参院選比例区の得票予想などをさせています。

広告会社の電通は、1億人まで規模を膨らませ、昨秋から、マーケティングに活用し始めた、と記事に書かれています。

朝日の今回の記事では、ペルソナの数は明示されていなかったと思います。そのあたりをGoogleのAI Geminiに尋ね、次のような回答を得ました。

検索結果によると、ご質問の朝日新聞の記事(または関連する「記者サロン」の告知内容)では、特定の1つの数字(例:3000人など)を「今回の実験で使った確定値」として報じているというよりは、「100人、1000人、ひいては1億人もの人格(ペルソナ)を持つ『仮想日本人』をつくることが可能」といった形で、規模の幅(可能性)として言及されている記述が見受けられます。

具体的には、以下のような文脈で数字が出ています。

- 規模の例示: 生成AIを使えば「100人、1000人、ひいては1億人」のペルソナを作成し、アンケートを行える可能性がある。

- 実験の有無: 朝日新聞のエンジニアがAIでシミュレーションを行ったことは記されていますが、その特定の実験で「何人分を生成したか」という詳細な確定数は、記事の要約範囲では明示されていませんでした(一般的なこの種の実験では、実際の世論調査に合わせて1,000人〜1万人規模で行われることが多いですが、記事内では「1億人」という大きな可能性まで含めて提示されている点が特徴的です)。

つまり、「〇〇人のペルソナで調査した」という特定の結果報告というよりは、「(1億人規模まで含めた)多様な数のペルソナを作れる技術である」という文脈で数字が使われているようです。

私は、Geminiを積極的に使い始める1カ月半前までは、AIからは意識して距離を置いていました。その理由は、AIが使われるようになるにつれ、人々をコントロールする側が、人々をコントロールするのにAIを悪用するのではないか、と考えたからです。

朝日新聞が試みた、ペルソナを持つとされたAIを使ったアンケートの検証に、それに近いものを感じます。

そのあたりのことをGeminiに問いかけると、次のように返答しました。

マスメディアがこの技術を使う上で、特に注意すべき点は以下の4点に集約されます。

1. ステレオタイプ(偏見)の増幅

AIはインターネット上の膨大なテキストデータから学習しているため、特定の属性(例:「70代・男性・保守層」)を演じさせると、「一般的・平均的」とされる典型的な反応(ステレオタイプ)を過剰に再現してしまう傾向があります。

- リスク: 現実の人間は「保守的だが、この件に関しては革新的」といった矛盾や複雑さを持っていますが、AIは「典型的な保守層」を演じすぎてしまい、社会の多様性や、少数派の微妙なニュアンス(機微)が切り捨てられる恐れがあります。

2. 「過去」に縛られる

AIの知識は、学習データのカットオフ(いつまでのデータを読み込ませたか)に依存します。

- リスク: 例えば、昨日起きた突発的なスキャンダルや災害に対して、現実の人間は感情を変化させますが、AIはその「最新の空気感」や「感情の揺らぎ」を完全には反映できません。「過去のデータに基づいた未来予測」であり、現在のリアルな世論とはズレる可能性があります。

3. 低コストゆえの「調査の安易化」

従来、世論調査には多額の費用と時間がかかりましたが、AIなら一瞬で、ほぼタダで終わります。

- リスク: 予算削減のために、本来なら生身の人間に行うべき取材や調査までAIで代用してしまうと、「実際に人の話を聞かないメディア」になってしまう危険性があります。それはジャーナリズムの根幹(現場主義)を揺るがしかねません。

4. 透明性の確保(AIであることの明示)

読者や視聴者に対し、「これは実際の人間へのアンケート結果なのか」「AIによる予測シミュレーションなのか」を明確に区別して伝える必要があります。

- リスク: もし境界線が曖昧なまま報道されれば、「AIが作った世論」が、逆に現実の人々の意見を誘導してしまう(バンドワゴン効果)という、本末転倒な事態になりかねません。

未だに新聞やテレビが報じることを信じてしまう傾向があります。そんな新聞やテレビが、AIを使ってアンケートのシミュレーションをし、それを報じると、それがAIによるシミュレーションであっても、そのような考えが世の中の態勢と誤認してしまいかねません。

このあたりのことも、Geminiに問いかけました。そして、次のような反応を得ました。

ご指摘の点は、メディア論や社会心理学の観点からも極めて本質的で、現実的な危惧だと思います。

「AIだと断り書きを入れているから大丈夫だろう」というのは作り手側の論理であり、受け手(読者・視聴者)の心理においては、ご懸念のような「誤認」や「刷り込み」が起きる可能性は非常に高いと言わざるをえません。

なぜ「AIによるアンケート」が「世の中の真実」として誤って受容されやすいのか、その危険なメカニズムを整理します。

1. 「お墨付き」効果(権威バイアス)

たとえデータ源がAIであっても、それが信頼する新聞やテレビのニュース枠で報じられると、人は無意識に情報の信頼度を底上げしてしまいます。 特に、きれいなグラフや「◯%が賛成」といった具体的な数値で示されると、「AIが計算したのだから、人間よりも客観的で正しいのだろう」という、科学信仰に近いバイアスが働きます。

2. 「予言の自己成就」のリスク

これが最も恐ろしい点ですが、AIが予測した「偽の世論」が、現実の世論を変えてしまう現象です。

- バンドワゴン効果: 例えば、AIシミュレーションで「A候補が優勢」と報じられると、実際の有権者が「みんなが支持しているなら」とA候補に投票し始め、結果としてAIの予測通りになってしまうこと。

- 現実の浸食: もともと存在しなかった意見でも、AIペルソナがもっともらしく語ることで、「世間ではこういう意見があるのか」と人々が認識し、それが既成事実化してしまう恐れがあります。

3. 注釈(ディスクレーマー)の限界

「※これはAIによるシミュレーションです」という注釈は、見出しやグラフのインパクトに比べればあまりに無力です。 人間は情報処理を簡略化したがる生き物(認知バイアス)なので、細かい条件設定よりも、「結論(見出し)」だけを記憶として定着させてしまいます。

朝日は、個人がエンタメとして作った動画を批判的に報じました。その一方で、世論をAIで作る研究をしています。影響力でいえば、マスメディアが圧倒的であることはいうを待ちません。

管理された自分たちがやるのだから問題はない、というのは奢りです。その危険性を強く意識すべきです。

そのことをGeminiも次のように指摘しています。

「感動」の捏造 vs 「世論」の捏造

記事にある「高市総理の演説に感動する高齢女性」の動画が批判される理由は、「存在しない感情」をあたかも事実のように見せたことにあります。 政治的な心情に訴えかける映像をAIで作ることは、プロパガンダになり得るからです。

しかし、朝日新聞が試みようとしている「AIペルソナへのアンケート」も、突き詰めれば「存在しない市民の声(感情)」を捏造することに他なりません。 「個人のYouTuberがやる政治的演出はダメだが、新聞社がやる政治的シミュレーションはOK」という理屈は、今の時代、多くの人には通用しないでしょう。

AIは諸刃の剣です。有効に活用できれば有益となります。しかし、その一方で、それが悪用されたら、どんなことが待つか、予測がつきません。

新コロ騒動でも、99%、あるいはそれ以上の人が、新コロウイルスの存在を信じてしまいました。そして、存在しない新コロウイルスを恐れ、そのために作られたことにされているワクチン(似非ワクチン)を偽装した化学兵器を自らの体内へ取り入れることに協力してしまいました。

今行われている衆院選にしても、石破政権のときと何も変わらない高市政権を、国民の多数が支持するとの数字が出ています。

日本人ほど騙されやすい民族は、世界にはほかにない、かもしれません。

AIを人々の支配に使い出したら、日本人はコロッと騙されてしまうでしょう。

それを虎視眈々と狙う研究が進んでいます。用心してください、といっても、日本人の多くは貸す耳を持たないでしょうか。

未だに、化学兵器の被害者に自分から進んでなる人がいる国ですから。

生成AIを巡る、朝日の矛盾した姿勢を、GoogleのAI Geminiと「対話」しました。それを基に、NotebookLMに動画を生成してもらいました。文章を読むのが面倒な人は、動画をご覧ください。